- 赛题名称:Kaggle - LLM Science Exam

- 赛题类型:自然语言处理、大模型

- 赛题任务:使用LLM回答困难的问题

- 赛题链接?:

https://www.kaggle.com/competitions/kaggle-llm-science-exam

比赛背景

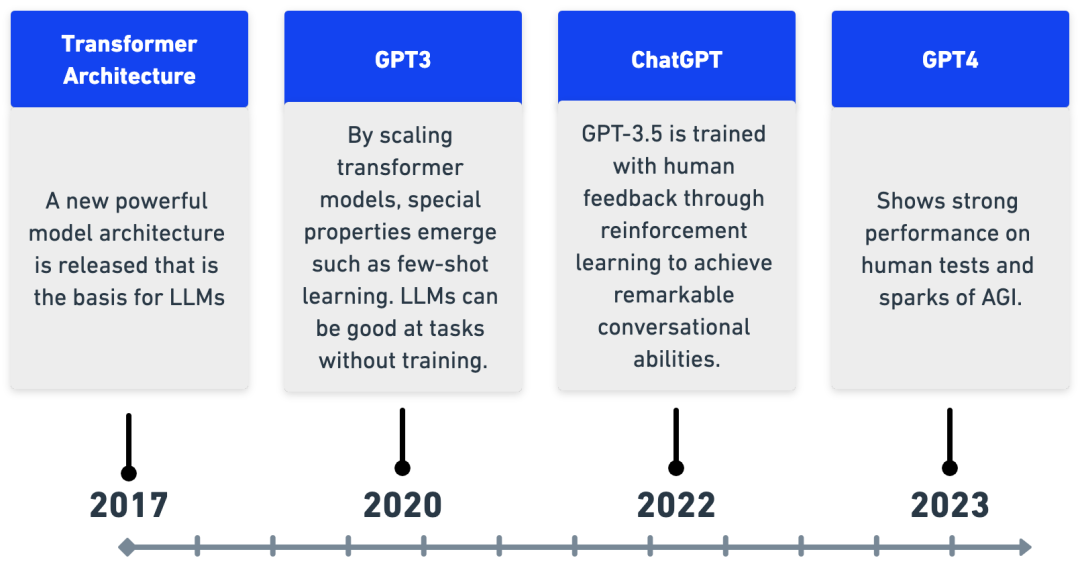

随着大型语言模型能力范围的扩大,越来越多的研究领域正在使用LLM来表征自己。由于许多现有的 NLP 基准已被证明对于最先进的模型来说是微不足道的,因此也有一些有趣的工作表明LLM 可用于创建更具挑战性的任务来测试更强大的模型。

与此同时,量化和知识蒸馏等方法被用来有效地缩小语言模型并在更普通的硬件上运行它们。Kaggle 环境提供了一个独特的视角来研究这一问题,因为提交内容受到 GPU 和时间限制。

此挑战的数据集是通过提供从维基百科提取的一系列科学主题的 gpt3.5 文本片段,并要求其编写多项选择题(带有已知答案),然后过滤掉简单的问题来生成的。

比赛任务

目前,我们估计 Kaggle 上运行的最大模型约有 100 亿个参数,而 gpt3.5 的参数为 1750 亿个。如果一个问答模型能够在由比其规模大 10 倍的问题编写模型编写的测试中表现出色,这将是一个真正有趣的结果; 另一方面,如果一个较大的模型能够有效地击败较小的模型,这对LLM自我基准测试和测试的能力具有引人注目的影响。

受OpenBookQA 数据集的启发,本次竞赛要求参与者回答使用大型语言模型回答基于科学的困难问题。您的工作将帮助研究人员更好地了解大型语言模型自我测试的能力,以及大型语言模型可以在资源有限的环境中运行的潜力。

评估指标

提交根据平均精度@3 (MAP@3) 评估:

一旦为测试集中的单个问题评分了正确的标签,该标签就不再被认为与该问题相关,并且在计算中会跳过该标签的其他预测。例如,如果A观察的标签正确,则以下预测的平均精度均为1.0。

[A, B, C, D, E]

[A, A, A, A, A]

[A, B, A, C, A]

赛题时间轴

- 2023 年 10 月 3 日- 报名截止。

- 2023 年 10 月 3 日- 团队合并截止。

- 2023 年 10 月 10 日- 最终提交截止。

赛题数据集

您在本次比赛中的挑战是使用LLMs回答多项选择题。虽然用于生成这些问题的过程的细节并未公开,但我们提供了 200 个示例问题及其答案,以显示格式,并给出测试集中问题类型的一般概念。

然而,样本问题和测试集之间可能存在分布变化,因此泛化到广泛问题集的解决方案可能会表现更好。每个问题由一个prompt(问题)和选项A以及B标记C的D正确E答案组成answer(这包含最正确答案的标签,由生成的 LLM 定义)。

本次比赛采用隐藏测试方式。对您提交的笔记本进行评分后,实际测试数据(包括提交的样本)将可供您的笔记本使用。测试集与提供的test.csv具有相同的格式,但有大约 4000 个问题,这些问题的主题可能有所不同。

文本说明

- train.csv - 一组 200 个问题以及答案栏

- test.csv - 测试集;你的任务是根据提示预测前三个最可能的答案。注意:您在这里看到的测试数据只是训练数据的副本,没有答案。看不见的重新运行测试集由约 4,000 个不同的提示组成。

- Sample_submission.csv - 正确格式的示例提交文件

列说明

- prompt- 所提出问题的文字

- A- 选项A;如果这个选项是正确的,那么answer将会是A

- B- 选项 B;如果这个选项是正确的,那么answer将会是B

- C- 选项C;如果这个选项是正确的,那么answer将会是C

- D——选项D;如果这个选项是正确的,那么answer将会是D

- E——选项E;如果这个选项是正确的,那么answer将会是E

- answer- 最正确的答案,由生成的 LLM 定义(A、B、C、D或之一E)

赛题思路

思路1:使用BERT完成多项选择,使用比赛数据集进行微调

使用BERT模型来完成多项选择的任务。BERT可以用于各种自然语言处理任务,包括多项选择题的回答。

思路2:使用现有的公开大模型进行微调,通过模型蒸馏和量化得到提交

选择使用现有的公开大模型,如GPT-3或其他类似的模型,作为基础模型进行微调。这些模型通常具有较大的参数量和更强大的语言理解能力。

赛题关键点

在这个比赛中,确实考虑到问题的性质和大型语言模型,最重要的是找到最适合的开源大型语言模型,并获取额外的数据。但由于训练集只有200个样例,这可能是一个挑战。

因此赛题可以考虑使用小模型,但使用外部方式来生成更多的高质量数据,这样也可以增加模型的精度。

赛题开源

https://www.kaggle.com/code/tanreinama/t5-loss-scoring-for-llm-science-exam

https://www.kaggle.com/code/zifencai/deberta-v3-large-inference

https://www.kaggle.com/code/takamichitoda/llm-perplexity-ranking-ensemble