文章目录[隐藏]

比赛名称 :Chinese Medical Instructional Video Question Answering

比赛类型 :视频定位问答,多模态

比赛链接 :https://cmivqa.github.io/

说在前面

?大家好!今天我们要来聊一聊2023年NLPCC共享任务5:CMIVQA。在这个信息爆炸的时代,人们对于学习新知识的需求越来越高,而视频作为一种直观、生动的方式,受到了越来越多的关注。特别是在医学领域,如何运用视频资源提供便捷的急救、医疗教育服务,成为了一个热门研究方向。?

那么,这个任务到底是什么呢?它的目标又是怎样的?我们又可以用什么方法去解决它呢?接下来就让我们一起探讨这个充满挑战和机遇的赛题吧!?

赛题任务?

本次共享任务主要包括三个子任务:单视频时序答案定位(TAGSV)、视频数据库检索(VCR)和视频数据库时序答案定位(TAGVC)。

-

单视频时序答案定位(TAGSV):给定一个医学或健康相关问题和一个未切割的中文医学教学视频,该任务旨在定位视频中与问题对应的时序答案(起始和结束时间点)。

- 输入:问题+单一视频

- 输出:视频区间

-

视频数据库检索(VCR):给定一个医学或健康相关问题以及一个大量未切割的中文医学教学视频集合,该任务旨在从视频集合中找到与问题最相关的视频。

- 输入:问题+视频库(多个视频)

- 输出:目标视频

-

视频数据库时序答案定位(TAGVC):给定一个文本问题和一个大量未切割的中文医学教学视频集合,该任务旨在在与问题最相关的视频中找到匹配的视频答案片段。

- 输入:问题+视频库(多个视频)

- 输出:目标视频区间

赛题分析?

赛题背景

在当前的视频问答研究中,大部分工作集中在英文领域,而中文视频问答研究相对较少。此外,医学领域具有很高的实用价值和挑战性,因此本次比赛选择了中文医学教学视频作为研究对象。

数据集

比赛所使用的数据集来自于YouTube网站上的高质量中文医学教学频道,由医学专家进行手动标注。数据集分为训练集、验证集和测试集。每个视频可能包含多个问题-答案对,每个问题对应一个唯一的答案。

任务难点

视频信息的多模态特性:视频中包含了丰富的视觉、文本、音频等信息,如何有效地利用这些信息是一个关键问题。

中文医学领域的挑战:中文自然语言处理和医学领域知识的结合,需要克服语义理解、领域专业术语等方面的难题。

时序答案定位的精确性:如何在海量视频中精确地找到与问题相关的答案片段,是一个技术难点。

可能的解决方案?

Textual-Based

我们可以利用文本信息来预测视频中答案的起始和结束时间点。例如,可以通过将问题和视频字幕进行编码,然后计算它们之间的相关性,以找到与问题最相关的字幕片段 (类似的NLP任务包括SQuAD等)。这种方法主要依赖于文本信息,可能会受到文本信息不完整或不准确的影响。因此当缺乏视频字幕时,可能难以准确定位目标信息。

Visual-Based

另一种方法是直接从视频帧中提取视觉特征,然后通过计算视觉特征与问题的相关性来定位答案。这种方法主要依赖于视觉信息,可能会受到视频质量或复杂场景的影响。尤其是问题文本和视频特征之间的语义偏差容易导致难以准确定位。

Multimodal-Based

既然文本和视觉方法各自有优缺点,那么结合两者的多模态方法是不是更好呢?这种方法可以充分利用文本和视觉信息,提高定位准确性。例如,我们可以采用以文本信息为主,并辅以视觉提示的做法,去训练模型 (例如VPTSL, https://arxiv.org/abs/2203.06667v2)。

官方解决方案?

单视频时序答案定位(TAGSV)

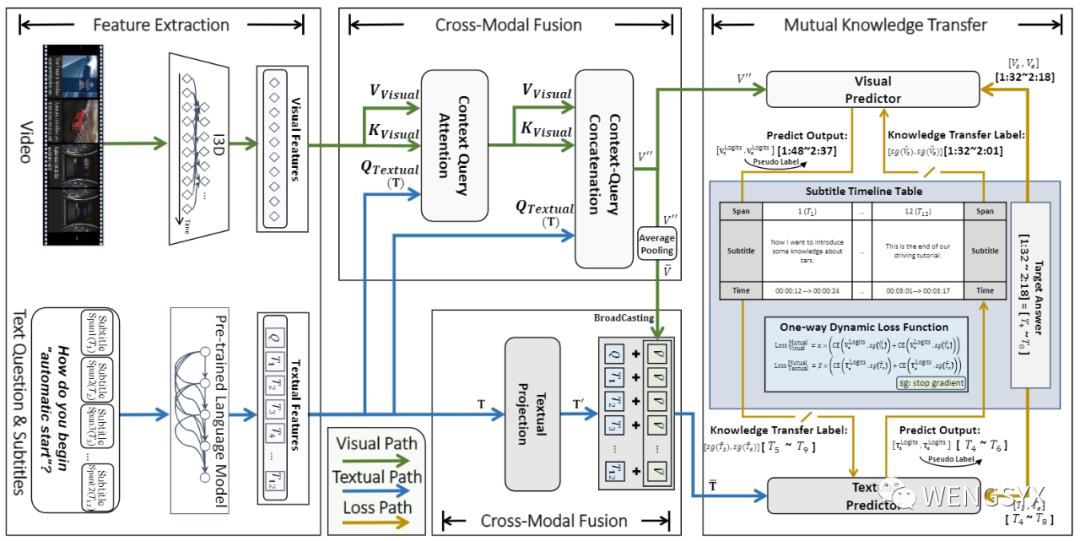

MutualSL (ICASSP 2023, CCF-B会议) 通过同时预测两个不同模态信息(视频与文本)的答案目标区间,并在训练过程中相互蒸馏,实现了解决视频视觉问答定位任务的跨模态知识偏差问题。

视频数据库检索(VCR) & 视频数据库时序答案定位(TAGVC)

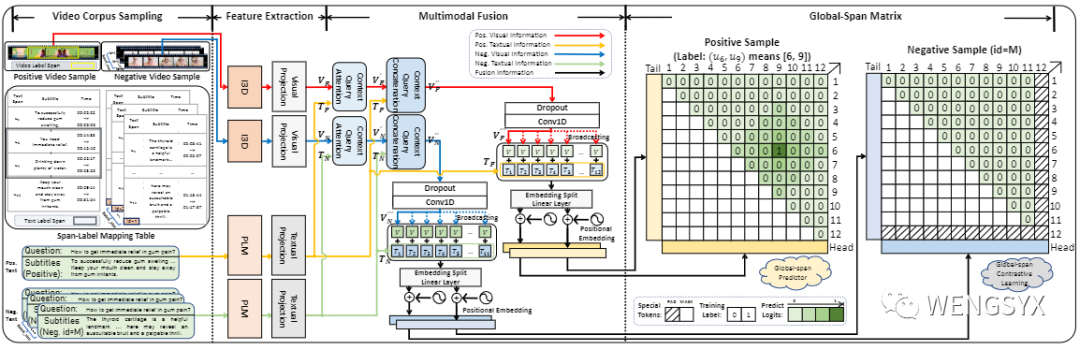

CCGS (ICASSP 2023, CCF-B会议) 通过 Golbal-Span 的方式将视频检索和视频定位建模到了同一个框架内,从而端到端地实现了视频数据库检索任务和视频定位问答。

更多关于方法描述和实现细节:https://github.com/WENGSYX/CMIVQA_Baseline

注意事项

baseline最低配置为11G的2080Ti显卡。如果遇到爆显存,其主要的原因是字幕的长度大多在2000个token,因此会占用大量的显存。如果您的显存不够,可以有以下两种解决方法:

-

修改max len,在main.py的CFG设置中修改max len以设置更低的最大文本长度(但是这一做法可能会排除一部分数据集)

-

换用其他的预训练模型,例如bigbird等,这些模型的显存占用不随文本长度的增加而大幅上升(但是这一做法需要修改model.py代码)

比赛奖金?

本次比赛将为表现突出的前三名团队颁发NLPCC和CCF-NLP颁发的证书,获奖者有机会并在NLPCC会议上宣讲论文并颁发现金奖励(税前)。

- ?一等奖:¥3000

- ?二等奖:¥2000

- ?三等奖:¥1000

赛事安排

- 测试A数据发布 2023年4月10日

- 比赛报名截止 2023年5月5日

- 测试B数据发布 2023年5月21日

- 测试B数据结果提交 2023年5月28日

- 比赛结果并征集论文 2023年6月10日

参考文献

[1] Li, Bin, et al. “Towards visual-prompt temporal answering grounding in medical instructional video.” arXiv preprint arXiv:2203.06667 (2022).

[2] Weng, Yixuan, and Bin Li. “Visual Answer Localization with Cross-modal Mutual Knowledge Transfer.” arXiv preprint arXiv:2210.14823. (Accepted in ICASSP 2023).

[3] Deepak Gupta, Kush Attal, and Dina Demner-Fushman. “A Dataset for Medical Instructional Video Classification and Question Answering.” arXiv preprint arXiv:2201.12888, 2022.

[4] Deepak Gupta, and Dina Demner-Fushman. “Overview of the MedVidQA 2022 Shared Task on Medical Video Question-Answering. ” BioNLP 2022@ ACL 2022 (2022): 264.

[5] Zhang, Hao, et al. “Natural language video localization: A revisit in span-based question answering framework.” IEEE transactions on pattern analysis and machine intelligence 44.8 (2021): 4252-4266.

[6] Li, Bin, et al. "Learning to Locate Visual Answer in Video Corpus Using Question." arXiv preprint arXiv:2210.05423. (Accepted in ICASSP 2023).